先做个广告:如需代注册ChatGPT或充值 GPT5会员(plus),请添加站长微信:gptchongzhi

OpenAI抢在 Google 2024 年 IO 大会之前,于北京时间5月14日凌晨发布了GPT-4o模型。

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

GPT-4o中的"o"代表"omni",意味着该模型在处理文本、语音和视频方面的全面能力,旨在实现更自然的人类-计算机交互。

GPT-4o在速度上比GPT-4也有所提升,比如它在生成Token时比GPT-4 Turbo快两倍,同时在价格上比GPT-4 Turbo便宜50%。

OpenAI还宣布,GPT-4o将向所有用户免费开放,这意味着任何人都可以通过ChatGPT访问到这一最先进的技术。

GPT-4o与GPT-4在有哪些具体的不同?

多模态能力:GPT-4o采用了端到端的训练方法,能够跨文本、视觉和音频进行处理,这一点在GPT-4中并未明确提及。这种多模态能力使得GPT-4o在理解和生成包含多种类型数据的内容时更为高效和灵活。 响应速度和成本:GPT-4o在响应速度上有显著提升,相比于GPT-4,其调用API的速度更快,同时开发者的实施成本也降低了50%。 视觉能力:GPT-4o在视觉处理方面表现优于GPT-4 Turbo,在处理图像等视觉信息方面具有更高的能力和效率。 语言支持:GPT-4o改进了对非英语语言的支持,这是GPT-4 Turbo所不具备的。这意味着GPT-4o在全球范围内的应用可能更加广泛,因为它能更好地服务于非英语用户。 上下文窗口和知识截止日期:GPT-4o的当前上下文窗口为128k,而其知识截止日期为2023年10月。这使得GPT-4o能够处理更长的文本序列,并且能够利用最新的信息进行交互。

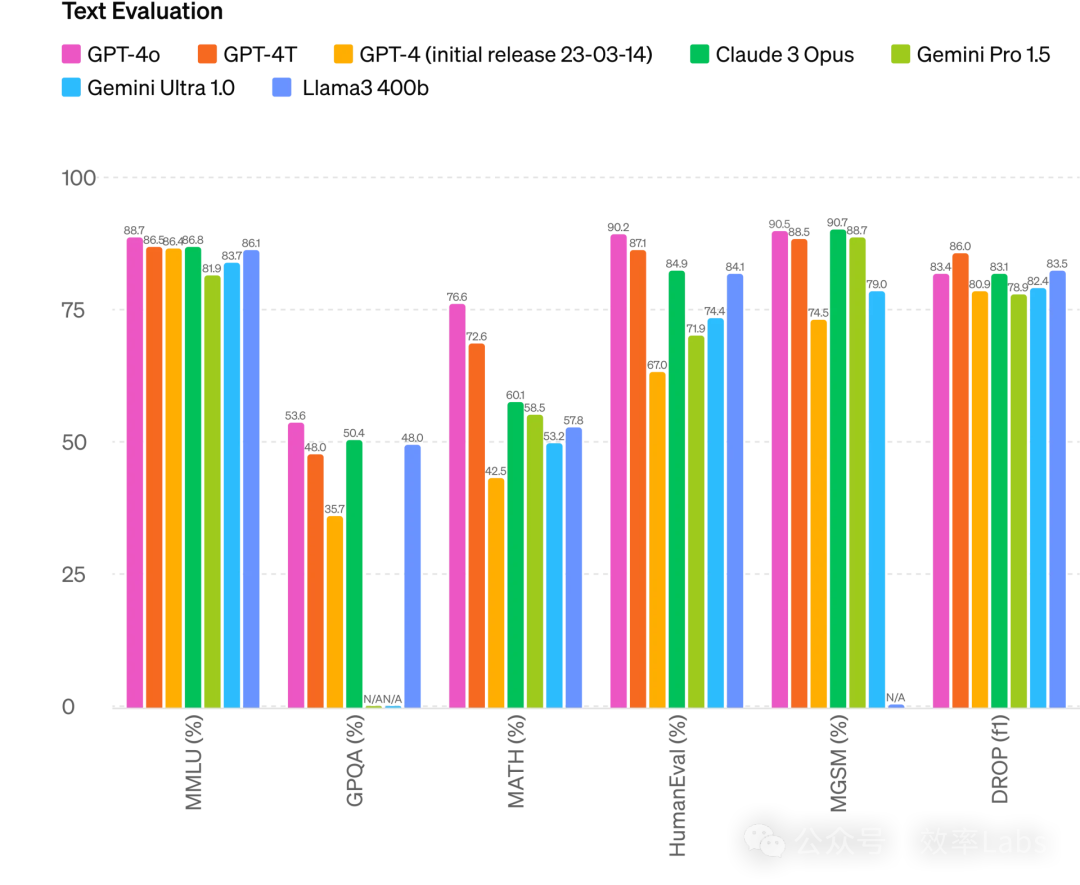

我们可以看一下官方公布的GPT-4o在基准测试中的表现。

GPT-4o的多模态处理能力

GPT-4o的语音处理能力主要通过其快速响应时间和高度准确的理解能力来实现。与其他AI模型相比,GPT-4o的优势在于其能够在毫秒级别上响应用户查询,这一速度与人类在日常对话中的反应速度相当。

具体来说,GPT-4o可以在最快232毫秒的时间内响应音频输入,平均响应时间为320毫秒,几乎接近人类在交谈中的响应时间。此外,GPT-4o不仅能处理文本、音频和图像的输入,还能生成这些三种形式的输出,大幅提升了模型的应用灵活性和实用性。这种全能型(omni)AI模型的推出,使得GPT-4o在实现更自然的人机互动方面迈出了重要一步。

GPT-4o的语音处理能力也体现在其能够实时推理音频、视觉和文本。这种能力使得GPT-4o在处理复杂的语音输入时,不仅能够理解和回应,还能跨越不同的输入模式,如文本、音频和视觉,从而提供更加丰富和多元化的交互体验。

OpenAI宣布GPT-4o将向所有用户免费开放

OpenAI宣布GPT-4o将向所有用户免费开放的详细计划包括以下几个方面:

免费开放给所有用户:OpenAI计划向所有用户免费提供GPT-4o,这意味着无论是ChatGPT Plus用户还是普通用户,都可以在未来几周内享受这一服务。 数量限制和自动切换:虽然GPT-4o的能力会向免费用户开放,但会有数量限制。达到上限后,系统会自动切回GPT-3.5。这表明即使是免费用户也不能无限制地使用所有功能,而是有一定的限制。 API开放给开发者:除了对普通用户开放外,OpenAI还计划通过API开放给开发者使用。这意味着开发者可以利用GPT-4o进行各种应用开发,同时也能享受到一些特定功能,如语音交互等。 与其他模型的关系:OpenAI还计划推出GPT-3.5 Turbo,以及DALL·E和Whisper的API接口。这表明OpenAI不仅在推广其最新模型,还在尝试整合更多的技术和服务,以满足不同用户的需求。 未来发布计划:OpenAI还计划在未来几周内逐步推出GPT-4o的各项能力,包括文本和图像处理能力。这些能力将从发布会后当天开始在ChatGPT中推出,Plus用户可以抢先体验。

本文链接:https://shikelang.cc/post/1245.html

chatgpt 注册ChatGPT和AIchatgpt年费跟付费的区别chatgpt是免费使用还是付费chatgpt4.0申请chatgpt app图标专家和chatgpt 谁的建议更靠谱chatgpt变现利用chatGPT学习chatgpt plus插件

网友评论