先做个广告:如需代注册ChatGPT或充值 GPT5会员(plus),请添加站长微信:gptchongzhi

OpenAI 在春季更新活动中发布了名为GPT-4o的新旗舰人工智能模型("o "表示 "omni",意思是全能的)。这个模型对所有用户开放,无论是免费用户还是付费用户都可以使用。

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

这表明OpenAI正在积极推动人工智能的普及,让更多人可以更方便地使用人工智能。

GPT-4o性能媲美GPT-4 Turbo,但在处理音频、图像和文本输入时速度更快。

这个模型着重于理解语音的语调,并提供实时的音频和视觉体验。与 GPT-4 turbo 相比,它的速度快两倍,价格便宜 50%,速率限制提高 5 倍。

OpenAI通过线上直播的形式,向用户演示了一个新的语音助手,让所有人都可以看到并了解他们的最新进展。

如何使用 OpenAI GPT-4o?

现在,所有 ChatGPT 用户(包括免费用户)都可以使用 GPT-4o。在此之前,只有付费订阅用户才能使用 GPT-4 类型的模型。

不过,付费用户的使用次数是免费用户的 5 倍。

在 GPT-4o 之前,语音模式和 ChatGPT 对话的平均延迟时间分别是 2.8 秒(GPT-3.5)和 5.4 秒(GPT-4)。

这个过程涉及三个独立的模型:将音频转录为文本的模型,接收文本输入并输出文本的 GPT 中央模型,以及将文本转换回音频的模型。

这就意味着,主要的智能源 GPT-4 会丢失很多信息—它不能直接观察到语调、多人对话或背景噪音,也不能输出笑声、歌声或表达情感的声音。

GPT-4o 是一个端到端的模型,它通过文本、视觉和音频数据进行训练。也就是说,所有的输入都由一个神经网络处理。这是 OpenAI 开发的第一个全方位模型,所以 GPT-4o 的功能还在初级阶段。

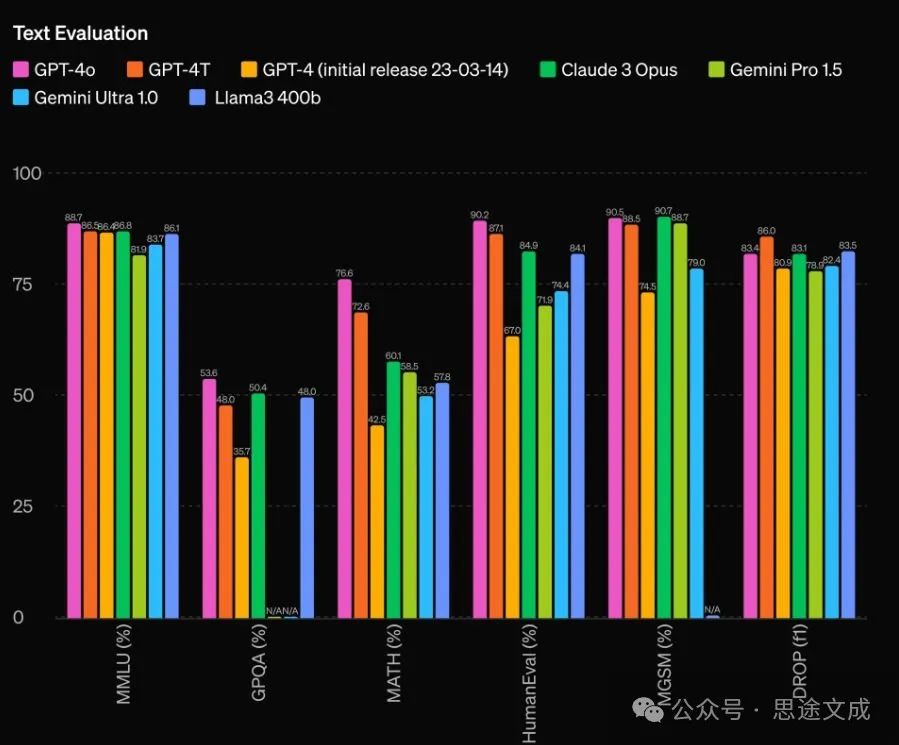

GPT-4o评估和性能

这个模型已经通过了传统行业的评估标准。GPT-4o在处理文本、推理和编码智能方面的表现,已经达到了GPT-4 Turbo的水平,而且在处理多语言、音频和视觉方面的能力取得了新的突破。

此外,该模型还开发了一种新的标记生成器,可以更好地压缩不同语言的语言。

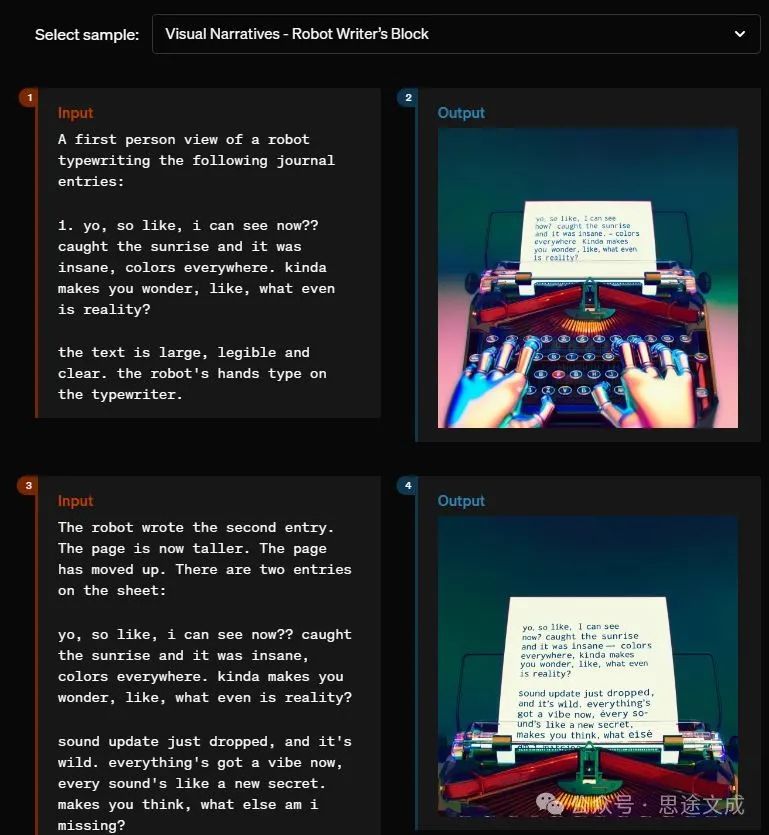

OpenAI 在他们的发布博客中使用许多不同的示例,详细解释了该模型的各项功能。

研究人员还讨论了该模型的限制和安全性。

我们意识到,GPT-4o 的音频模式可能带来各种新的风险。今天,我们公开发布了文本和图像输入以及文本输出。在接下来的几周和几个月里,我们将致力于改善技术基础设施、通过后期培训提高可用性,并确保发布其他模式的安全性。例如,在推出时,音频输出将只能选择预设的声音,并且将遵守我们现有的安全政策。我们将在即将推出的系统卡中,分享更多关于GPT-4o所有模式的详细信息。

— OpenAI

人工智能公司一直在努力提升计算能力。之前的语音交互模式中,转录、智能和文本到语音三种模型共同作用,导致了较高的延迟,影响了沉浸式体验。

然而,有了 GPT-4o,这一切都可以通过调整其语音输出的特性来与用户进行自然和流畅的交流,而且几乎没有等待时间。对于所有用户来说,GPT-4o无疑是一个非常有趣而神奇的工具!

本文链接:https://shikelang.cc/post/1248.html

OpenAI GPT-40GPT-40是什么GPT-4o抢先测GPT-40在哪用gpt-4o功能介绍GPT-40怎么用GPT-4o正式亮相GPT-4试用

网友评论