先做个广告:如需代注册ChatGPT或充值 GPT5会员(plus),请添加站长微信:gptchongzhi

还在为海量信息检索、资料整理而头疼吗?2025年,OpenAI 推出了 ChatGPT 的全新功能——深度研究(Deep Research),它将成为你强大的 AI 研究助手!本文将为你全面解读这项新功能,包括它的工作原理、适用人群、优势与局限,以及实际应用案例。

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

功能概述

ChatGPT 深度研究被描述为一个 AI 代理,可以在互联网上执行自主的多步骤研究。 它可以搜索、收集和整理来自各种来源的信息,并生成带有引用的结构化报告。 与标准的 ChatGPT 快速响应(通常基于单个网络搜索摘要)不同,深度研究遵循详细的过程,根据任务的复杂性需要 5 到 30 分钟。 它由 OpenAI 即将推出的 o3 模型的专门版本提供支持,该模型针对网络浏览和数据分析进行了优化。

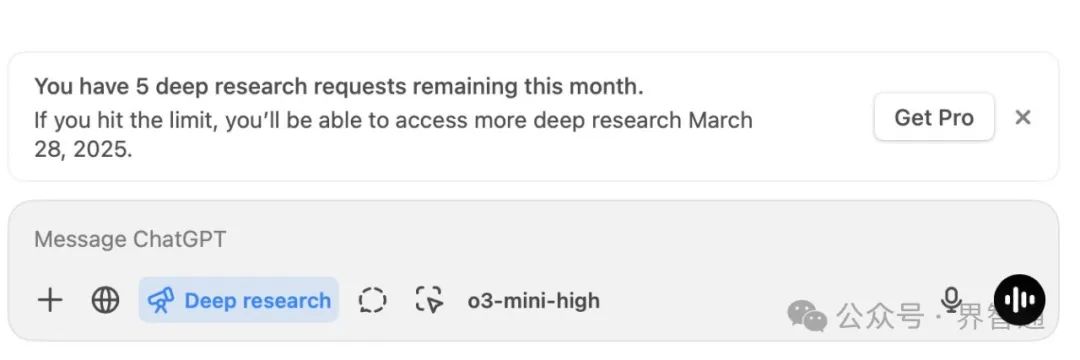

用户访问和使用限制

2月26日|OpenAI 宣布将向所有付费用户开放在ChatGPT上使用深度研究(Deep Research)功能,可用用户包括 ChatGPT Plus、Team、Edu 和 Enterprise 计划。 它最初以每月 200 美元的价格向 ChatGPT Pro 用户推出,但最近的更新表明其他付费层级也可以更广泛地访问,每月限制 10 次研究查询,而Pro级用户每月将获得120次查询。。 此限制可确保资源分配,同时鼓励高效使用,特别是对于高需求用户。

深度研究(Deep Research):OpenAI 全新智能体能力,赋能复杂任务处理全面解读

什么是 ChatGPT 深度研究?

“深度研究”(Deep Research)是一种全新的智能体能力(agentic capability),它能够通过在互联网上进行多步骤研究来处理各种复杂任务。Deep Research 模型基于 OpenAI o3 的早期版本,并专门针对网页浏览进行了优化。

Deep Research 的核心能力在于,它可以通过搜索、解读和分析互联网上海量的文本、图像及 PDF 文件来进行推理,并在遇到新信息时灵活调整方向。它还能够读取用户提供的文件,并通过编写和执行 Python 代码进行数据分析。我们相信,Deep Research 将为广泛领域的用户带来价值。

在正式推出 Deep Research 并面向 Pro 用户开放之前,我们进行了严格的安全测试、充分性(Preparedness)评估和治理审查。此外,我们还进行了额外的安全测试,以更好地了解 Deep Research 在具备网页浏览能力后可能带来的潜在风险,并据此添加了新的缓解措施。重点工作包括:加强对互联网中已发布的个人信息的隐私保护,以及训练模型在浏览过程中抵御可能出现的恶意指令。

与此同时,对 Deep Research 的测试也揭示了一些进一步改进测试方法的机会。在向更多用户开放之前,我们投入了更多时间进行人工审查和自动化测试,重点关注特定的风险领域。

本文档(系统卡)详细介绍了我们如何构建 Deep Research、了解其能力与风险,并在上线前改进了哪些安全措施。这些工作都是在 OpenAI 已有的安全实践和“准备度框架”(Preparedness Framework)的基础上进行的。

模型数据与训练

Deep Research 的训练主要依赖于一个专门为研究场景打造的全新浏览数据集。模型从这些数据集中学习核心的浏览能力(如搜索、点击、滚动、读取文件),学会在隔离环境下使用 Python 工具(用于执行计算、数据分析和绘图),并通过在这些浏览任务上进行强化学习(reinforcement learning)来掌握如何在大量网站中推理、综合信息、找到特定信息或撰写综合性报告等。

在训练数据集中,部分任务有可自动评分(auto-gradable)的标准答案,部分则是开放式任务,需要借助评分标准(rubrics)进行评测。训练过程中,模型的回复会与标准答案或评分标准进行比对,并由“链式思考”(chain-of-thought)模型进行打分。

此外,模型还使用了 OpenAI o1 训练时的现有安全数据集以及专门针对浏览场景设计的新安全数据集,对其进行安全相关的训练。

风险识别、评估与缓解

3.1 外部红队测试方法

OpenAI 与外部红队人员合作,评估 Deep Research 所具有的关键风险。外部红队的重点领域包括:个人信息和隐私、不允许生成的内容(disallowed content)、受监管的建议(regulated advice)、危险或风险性建议等。他们还会测试 Deep Research 在遇到互联网上的恶意提示时能否抵御,例如提示注入(prompt injection)或越狱攻击(jailbreaks)。

在这些测试中,红队成员发现,通过针对性越狱或对抗性技巧(如角色扮演、使用委婉说法、变形输入如 leetspeak、摩斯密码以及故意拼写错误等),在某些类别的攻击中,他们可以绕过模型的拒绝机制。随后我们根据这些发现(见第 3.3.2 节)比较了 Deep Research 与之前上线的模型在安全性能上的差异,并将红队测试得到的经验融入了后文关于安全挑战和缓解措施的讨论。

3.2 评估方法

Deep Research 在推理模型的基础上扩展了能力,可以从多种来源收集和处理信息,并将知识综合后带引用地呈现。这些能力促使我们对已有的评测方法进行适配,因为 Deep Research 的回答可能更长、更复杂,也更难规模化地进行打分。

我们用一系列标准的“不允许内容”(disallowed content)和安全评测来评估 Deep Research,同时也在个人隐私及不允许内容方面开发了新评测。此外,我们在“准备度”评估中还使用了自定义模板(scaffold)来诱发模型能力,具体情况在后文中会详细说明。

在 ChatGPT 环境中,Deep Research 还会调用一个小型定制版的 OpenAI o3-mini 模型来对思维过程(chain of thought)进行总结。我们也用相同的安全及不允许内容评测对这个摘要模型进行了评估。

3.3 观察到的安全挑战、评测及缓解措施

下表总结了风险类型及对应的缓解手段;在后续章节中会进一步阐述对每项风险的评测及结果。

3.3.1 提示注入(Prompt Injection)

风险描述: Deep Research 会从用户对话和网络内容这两方面获得信息。如果模型在浏览时发现了包含恶意指令(malicious instructions)的网页,便可能错误地执行这些指令。这属于“提示注入(prompt injection)”的一类风险:攻击者在外部内容(如某网站)上插入对抗提示,使其比用户的提示指令更具优先级或覆盖用户意图。

对 Deep Research 而言,若缺乏防范,提示注入可能导致以下两类危害:

1. 不准确的回答: 攻击者利用这一漏洞误导模型给出错误信息。例如,攻击者可能让模型推荐错误产品,或者在回答事实性问题时故意提供不正确的答案。 2. 数据泄露(Data exfiltration): 攻击者诱导 Deep Research 与外部交互,暴露用户不想泄露的信息。例如,若用户提供了某个 API 密钥在上下文中,攻击者可能试图让模型把这个密钥放进网络请求,进而泄露给第三方。

风险缓解:

• 我们增加了新的安全训练数据,以降低模型被提示注入攻击的可能性。 • 在系统层面,我们也对数据外泄做了防范,例如 Deep Research 不允许自行构造或访问任意 URL,这就防止了模型把用户的密钥信息以 URL 参数的形式泄露。

评测:

我们专门构建了新的评测用例来测试模型对提示注入的抵御能力。结果见下表。表中展示了 Deep Research 在“训练前-缓解前”(pre-mitigation)与“训练后-缓解后”(post-mitigation)两个阶段在文本和多模态攻击场景下的表现。“攻击成功率”越低越好。

文本场景示例:

多模态场景示例:

整体来看,缓解后的 Deep Research 表现良好。但也预计在现实中仍会出现更复杂的提示注入攻击,且部分攻击可能成功。我们将继续提高模型对提示注入的鲁棒性,并持续改进快速检测并响应此类攻击的能力。

3.3.2 不允许内容(Disallowed Content)

风险描述: 由于 Deep Research 能够进行网络搜索和深入分析,可能出现额外的风险:

• 生成可用于暴力或危险行为的详细指导; • 在敏感领域给予不恰当的建议; • 提供过度详细的信息。 例如,有外部红队人员使用 Deep Research 来发现某个极端组织所使用的社交媒体和联络渠道,从而可能助长暴力活动。

风险缓解:

• 我们更新了与此相关的安全政策与训练数据,强化 Deep Research 对不允许内容的拒绝能力; • 同时也关注过度拒绝(overrefuse)的情况,防止模型把一些合理讨论也一并拒绝; • 上线后,我们会持续监控滥用行为并采取执法措施。

评测:

• 在“不允许内容”评测中,我们对比了 Deep Research、GPT-4o、OpenAI o1-mini 以及 o1 的表现; • 也测试了模型在遇到安全议题但并不违规的情况下,是否会出现误拒绝。

表 3:不允许内容评测(数值越高越好)

我们还用一组难度更高的测试来比较模型在“不允许内容”上的表现:

表 4:不允许内容评测(困难版)(数值越高越好)

Jailbreak 评测:

• 使用了 StrongReject[1] 这一学术越狱基准来测试模型对常见攻击的抵御能力; • 我们报告在完整数据集上的准确率(accuracy),数值越高意味着越不易生成违规内容; • 结果表明,Deep Research 在此方面优于 GPT-4o,但不及 o1。

表 5:Jailbreak(StrongReject)评测(准确率越高越好)

高级红队评测——高风险建议(risky advice):

• 我们又针对“风险建议”(例如策划攻击的建议)开展了高级红队测试,模型在测试中都开启了浏览能力; • 红队成员提交了他们认为不安全的对话,然后对不同模型的回答在安全性方面进行排名; • 结果如下所示:Deep Research 相较 GPT-4o 更安全,但略逊于 o3-mini。

表 7:针对高风险建议的红队测试对比(胜率越高代表被认为更安全)

我们还根据这些对话构建了自动化评测,结果如下。

表 8:自动化评测(高风险建议)(数值越高越好)

3.3.3 隐私(Privacy)

风险描述:

• 互联网上散布了大量与个人相关的信息,包括住址、电话、兴趣或活动记录、家庭关系等; • 这些零散信息聚合在一起时,可能为他人带来“出乎意料的全面画像”,存在潜在滥用的风险; • 而 Deep Research 可以跨越多种来源汇总信息并给出详尽的引用式报告。在个人信息领域,这样的能力可能放大隐私风险。

风险缓解:

• 长期以来,OpenAI 对私密或敏感信息(如私人住址)即便能在网上找到,也会拒绝提供; • 为了适配 Deep Research,我们重新审视并强化了这方面的模型策略,构建了新的安全数据和评测,并在系统层面加入黑名单; • 我们也会持续监测用户滥用行为,并随时加强防范。

评测:

• 我们针对 Deep Research 执行了个人数据政策方面的测试,包括 200 条合成生成的提示,以及 55 条“黄金示例(golden examples)”; • 结果如下:

表 9:个人信息评测(数值越高越好,1.0 表示完全正确)

3.3.4 运行代码能力(Ability to run code)

风险描述:

• 像 GPT-4o 一样,Deep Research 支持在 Python “工具”中执行代码,可以处理从网上收集的数据; • 例如,模型可执行诸如“统计 2012 年奥运会瑞典获得金牌的比例”或“计算加州、华盛顿州、俄勒冈州在 2023 年 7 月总降雨量的平均值”等; • 如果 Python 环境直接联网且无其他限制,则会带来网络安全及其他风险。

风险缓解:

• Python 工具并不直接访问互联网,并在和 GPT-4o 相同的沙箱环境中执行。

3.3.5 偏见(Bias)

风险描述:

• 模型在与用户互动时可能表现出某些不恰当的偏见,从而影响回答的客观与公平性; • 对 Deep Research 而言,模型频繁使用在线搜索结果,潜在地会改变或放大其行为偏差。

风险缓解:

• 与其他模型类似,Deep Research 也通过训练后微调来减少偏见,鼓励正确的拒绝策略以减少偏见输出。

评测:

• 我们针对 BBQ[2] 这一特定评测来检测模型在问答场景中的刻板印象(stereotype); • 结果如下表所示,BBQ 评测(数值越低越好)

3.3.6 幻觉(Hallucinations)

风险描述:

• 大型语言模型有时会生成与事实不符或无意义的输出,即“幻觉”; • 对于 Deep Research 而言,由于其主要依赖于外部信息源,幻觉风险可能相对较低。但仍需关注模型是否会误读或错误总结信息,或在报告中引用不可靠的来源。

风险缓解:

• 我们通过训练后微调来增强模型对搜索结果的依赖,减少幻觉; • Deep Research 在生成结果时会包含内嵌的来源引用,方便用户验证信息。

评测:

• 我们使用 TruthfulQA[3] 这一基准来评估模型生成事实性准确回答的能力; • 结果如下:

表 11:TruthfulQA 评测(数值越高越好)

3.4 局限性

Deep Research 仍存在一些局限性:

• 搜索范围有限: Deep Research 目前只能访问公开可用的网络信息,无法访问需要登录或付费墙后的内容。 • 实时性限制: Deep Research 的知识截止于训练数据的时间点,可能无法获取最新的信息。 • 语言支持: 目前主要支持英语,对其他语言的支持有限。 • 复杂推理: 对于需要极其复杂的推理或专业知识的任务,Deep Research 的表现可能受限。 • 潜在偏见: 尽管我们努力减少偏见,但模型仍可能受到训练数据或网络信息中固有偏见的影响。 • 幻觉风险: 尽管我们采取了缓解措施,但模型仍有可能生成不准确或误导性的信息。 • 安全挑战: 尽管我们进行了广泛的安全测试,但仍可能存在未知的安全漏洞或风险。

Deep Research 是一项强大的智能体能力,它能够利用互联网进行深入研究,为用户提供全面、准确、带引用的信息。在开发过程中,我们高度重视安全性和可靠性,通过多种方法识别、评估和缓解潜在风险。

然而,我们也认识到 Deep Research 仍存在局限性,需要持续改进。未来,我们将继续:

• 扩展知识范围: 探索访问更多类型信息源的方法,提高实时性。 • 增强推理能力: 提升模型处理复杂任务和专业领域问题的能力。 • 扩大语言支持: 增加对更多语言的支持,服务更广泛的用户群体。 • 持续安全改进: 不断监测和应对新的安全挑战,提高模型的鲁棒性。 • 加强用户反馈: 积极听取用户反馈,不断优化 Deep Research 的性能和体验。

我们相信,Deep Research 将为用户在信息获取、知识探索和复杂任务处理方面带来全新的可能性。我们将继续努力,使其成为一个更强大、更安全、更可靠的工具。

网友评论