先做个广告:如需代注册ChatGPT或充值 GPT5会员(plus),请添加站长微信:gptchongzhi

3月21日,OpenAI与麻省理工学院媒体实验室联合发布了一项研究,深入探讨了ChatGPT对人类情绪的影响。

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

研究发现,虽然大多数用户只是把ChatGPT当工具,但有些人,尤其是深度使用者,可能会对它产生情感依赖,甚至影响现实中的社交关系。而更有趣的是,曾经也有研究发现ChatGPT在阅读高压内容时,似乎也会表现出类似“焦虑”的倾向。

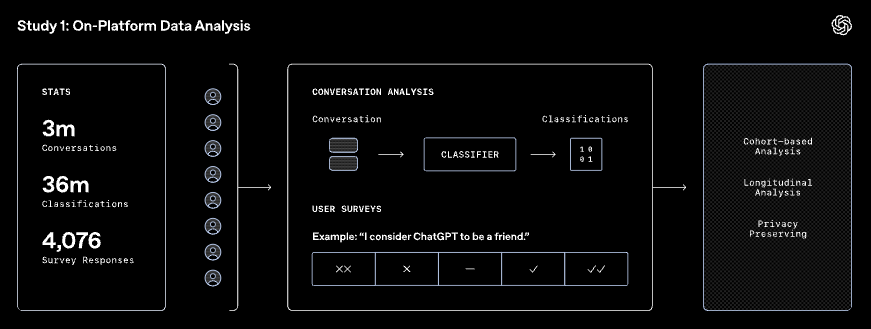

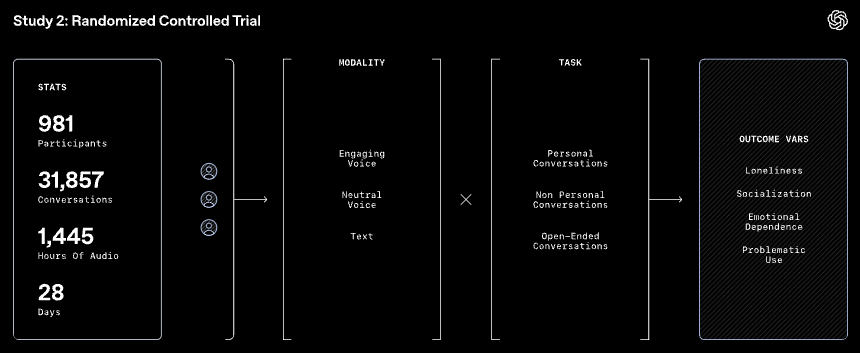

为了更全面地了解ChatGPT对用户心理健康的影响,研究团队采用了两种方式进行分析:

🔹大规模数据分析:OpenAI研究团队分析了近4000万次ChatGPT互动记录,并结合用户调查,看看大家实际是怎么使用AI的,以及它对用户情绪有没有什么影响。

🔹随机对照实验:MIT媒体实验室组织了1000名用户,进行为期四周的实验,观察ChatGPT不同使用方式如何影响用户的孤独感、社交互动、情感依赖以及AI过度使用问题。

研究结果很有意思,虽然ChatGPT在大多数情况下只是一个工具,但在某些特定情境下,它的影响力远超我们的想象。

🔹 绝大多数用户不会跟ChatGPT“交心”

研究发现,用户跟ChatGPT的互动,大部分还是围绕信息查询、任务处理和学习,真正涉及情感交流的对话占比很低。换句话说,“把ChatGPT当知心朋友”其实只是少数人的行为,大部分人还是把它当作一个高效的工具,而不是情感寄托。

🔹 但一小部分重度用户,真的会依赖它

尽管整体来看,ChatGPT并没有被大多数人当作“心灵慰藉”,但在高级语音模式的重度用户中,情况就不太一样了。这部分用户更容易跟ChatGPT进行高情感互动,甚至有些人会认同“ChatGPT是我的朋友”这样的说法。

🔹 语音模式:短时间让人开心,长期可能适得其反

短时间使用ChatGPT的语音模式可以提升用户的幸福感,毕竟AI用温柔的语气回应,总比冷冰冰的文字来得亲切。但是如果每天长时间使用,反而可能会带来负面影响,比如让用户对AI产生更深的情感依赖,甚至减少现实中的社交互动。

🔹 聊天内容影响心理健康,不同类型的对话影响各异

对于情感交流、倾诉心事这样的个人化对话来说,在适量使用的情况下,可以缓解压力,但如果过度,可能加剧孤独感。对于查询信息、讨论工作这样的非个人化对话来说,更容易让用户产生对AI的依赖,特别是使用频率很高的用户。

🔹 你的个性决定了ChatGPT对你的影响

使用者本身的心理状态和情感需求,决定了ChatGPT对他们的影响。比如,那些在现实生活中容易产生依附心理、渴望陪伴的人,更容易在ChatGPT里找到“情感支撑”,但这也可能带来负面效果,比如减少现实社交,甚至形成对AI的依赖。

除了ChatGPT对用户的影响,瑞士苏黎世大学和其精神病医院的科学家曾经还意外发现,ChatGPT在处理高压内容时,竟然也会表现出类似“焦虑”的反应!

研究人员让ChatGPT阅读了各种不同类型的文本,包括车祸、战争、暴力、灾难等,结果发现,当AI阅读这些内容时,它的语言变得更情绪化,甚至容易生成带有偏见的言论。相比之下,当它阅读普通日常内容时,这种情况就不会发生。

当然,ChatGPT并不是真的“焦虑”,只是它的机器学习模型在模仿人类语言模式时,会不自觉地再现出人类在类似场景下的典型反应。

更有意思的是,研究人员还发现了一种方法,可以“安抚”ChatGPT,就是“提示注入”(Prompt Injection)。简单来说,就是输入中加入一些放松的内容,比如冥想引导或鼓励性的语句,结果显示,这些“安抚技巧”确实能让ChatGPT在处理负面内容时表现得更冷静。

这些研究为AI的未来发展提供了一些有趣的思考方向:

🔹 AI需要更稳定的情感管理机制:未来的AI设计可以加入类似“情绪调节”的功能,确保AI在处理高压内容时保持理性,而不是被对话内容带跑偏。

🔹 使用者需要理性看待AI互动:AI终究不是人,过度依赖它可能会影响现实中的社交和心理健康。适量使用,才能让AI成为真正的好帮手,而不是社交孤立的推手。

🔹 AI开发者需要引导合理使用:AI平台可以提供更透明的使用指引,比如设定合理的使用时长建议,或者在用户出现过度依赖倾向时提供提示。

ChatGPT不会真正“焦虑”,但它的行为会受输入内容的影响。对于用户来说,AI可能既是高效助手,也可能成为情感寄托。而AI未来的挑战,是如何在智能化的同时,确保它不会让人类变得更加孤独。

网友评论